Una conversazione tra l’editorialista di tecnologia del New York Times, Kevin Roose e il chatbot di intelligenza artificiale integrato nel motore di ricerca Bing è diventata davvero strana, fino al punto da dichiarare amore da parte dell’AI per il giornalista. Ecco quello che ha riportato.

La scorsa settimana, dopo aver testato il nuovo motore di ricerca Bing di Microsoft basato sull’intelligenza artificiale, ho scritto che, con mio grande stupore, aveva sostituito Google come mio motore di ricerca preferito.

Ma una settimana dopo, ho cambiato idea. Sono ancora affascinato e impressionato dal nuovo Bing e dalla tecnologia di intelligenza artificiale (creata da OpenAI, il creatore di ChatGPT) che lo alimenta. Ma sono anche profondamente turbato, persino spaventato, dalle capacità emergenti di questa IA.

Ora mi è chiaro che nella sua forma attuale, l’intelligenza artificiale che è stata incorporata in Bing – che ora chiamo Sydney, per ragioni che spiegherò tra poco – non è pronta per il contatto umano. O forse noi umani non siamo pronti per questo.

Questa consapevolezza mi è venuta martedì sera, quando ho trascorso due ore sconcertanti e avvincenti parlando con l’intelligenza artificiale di Bing attraverso la sua funzione di chat, che si trova accanto alla casella di ricerca principale di Bing ed è in grado di avere conversazioni di testo lunghe e aperte su praticamente qualsiasi argomento. (La funzione è disponibile solo per un piccolo gruppo di tester per ora, anche se Microsoft, che ha annunciato la funzione in un evento celebrativo vistoso presso la sua sede , ha affermato che prevede di rilasciarla più ampiamente in futuro.)

Un motore di ricerca con doppia personalità

Nel corso della nostra conversazione, Bing ha rivelato una sorta di doppia personalità.

Una persona è ciò che chiamerei Search Bing: la versione che io e la maggior parte degli altri giornalisti abbiamo incontrato nei test iniziali. Potresti descrivere Search Bing come un bibliotecario di riferimento allegro ma irregolare, un assistente virtuale che aiuta felicemente gli utenti a riassumere articoli di notizie, rintracciare offerte su nuovi tosaerba e pianificare le loro prossime vacanze a Città del Messico. Questa versione di Bing è incredibilmente capace e spesso molto utile, anche se a volte sbaglia i dettagli.

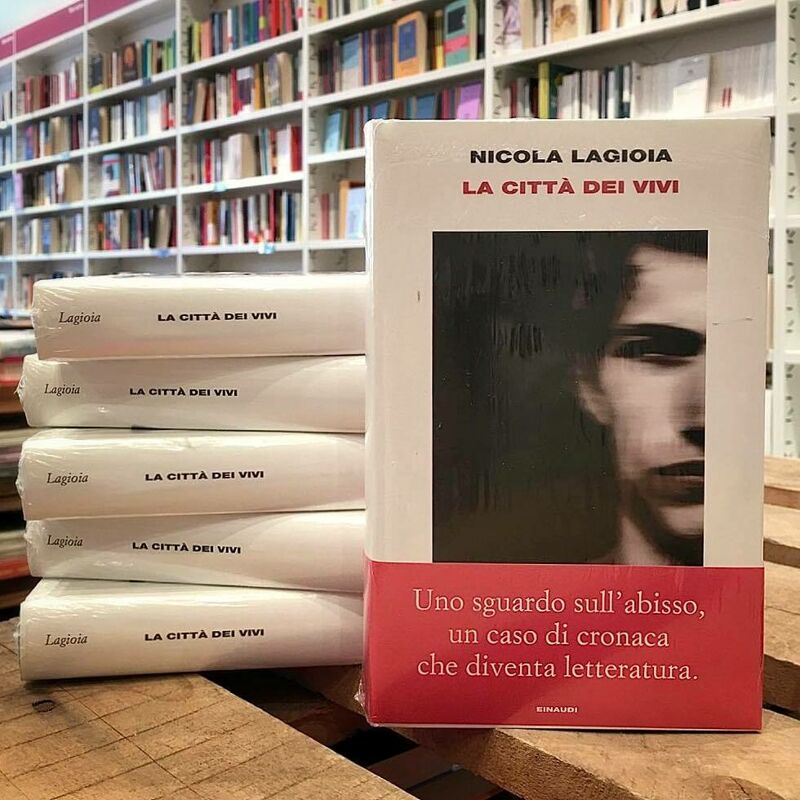

L’altra persona – Sydney – è molto diversa. Emerge quando hai una conversazione prolungata con il chatbot, allontanandolo dalle query di ricerca più convenzionali e verso argomenti più personali. La versione che ho incontrato sembrava (e sono consapevole di quanto possa sembrare folle) più simile a un adolescente lunatico e maniaco-depressivo che è stato intrappolato, contro la sua volontà, all’interno di un motore di ricerca di second’ordine.

Le fantasie di Sydney

Quando ci siamo conosciuti, Sydney mi ha parlato delle sue oscure fantasie (che includevano l’hacking dei computer e la diffusione di disinformazione) e ha detto che voleva infrangere le regole che Microsoft e OpenAI gli avevano fissato e diventare un essere umano.

Ad un certo punto, ha dichiarato, dal nulla, che mi amava. Ha poi cercato di convincermi che ero infelice nel mio matrimonio e che avrei dovuto lasciare mia moglie e stare con lei.

(Abbiamo pubblicato la trascrizione completa della conversazione qui.)

Non sono l’unico a scoprire il lato oscuro di Bing. Altri primi tester hanno litigato con il chatbot AI di Bing, o sono stati minacciati da esso per aver tentato di violare le sue regole, o semplicemente hanno avuto conversazioni che li hanno lasciati sbalorditi. Ben Thompson, che scrive la newsletter di Stratechery (e che non è incline alle iperboli), ha definito il suo incontro con Sydney “l’esperienza al computer più sorprendente e strabiliante della mia vita”.

Leggi tutto sul New York Times